El “cerebro social artificial” como mecanismo onto-fetichizante: responsabilidad dialógica y politicidad de la palabra en la era de la IA

The “artificial social brain” as an onto-fetishizing mechanism: dialogical responsibility and politicity of speech in the age of AI

Adrián R. Martínez Levy y Alberto Tena Camporesi

Recibido: 10/02/2025 / Aceptado para su publicación: 22/04/2025

Profesores investigadores en la División de Estudios Multidisciplinarios del Centro de Investigación y Docencia Económicas, A.C. México.

Resumen

Este texto ha surgido de discusiones recientes acerca del rol que la Inteligencia Artificial (IA) está adquiriendo en la reorganización del trabajo, la producción de conocimiento y las relaciones sociales bajo el capitalismo tecnológico. A partir del concepto de “cerebro social” que aparece en el conocido “Fragmento sobre las máquinas” de los Grundrisse de Marx, y algunos otros pertenecientes al llamado “Capítulo VI inédito” y al capítulo XIII (“Maquinaria y gran industria”) del tomo I de El Capital, el trabajo aquí presentado examina el modo en que la IA deja de ser una mera herramienta para convertirse en un agente central de lo que podemos denominar “subsunción cognitiva”, ampliando los horizontes de la dominación y la explotación capitalistas. De tal manera, inspirados en el análisis marxista de la “subsunción formal y real”, problematizamos la noción de “cambio ontológico” planteada por la IA y, a la vez, advertimos sobre la fetichización que encubre y naturaliza sus implicaciones políticas.

Palabras clave:

Inteligencia Artificial, fetichización, capitalismo tecnológico, subsunción cognitiva

Abstract

This text arises from recent discussions about the role that Artificial Intelligence (AI) is acquiring in the reorganization of work, knowledge production, and social relations under technological capitalism. Starting from the concept of the “social brain,” which appears in the well-known “Fragment on Machines” from Marx’s Grundrisse, and some others belonging to the so-called “Unpublished Chapter VI” and Chapter XIII (“Machinery and Large-Scale Industry”) of Volume I of Capital, the work presented here examines how AI ceases to be a mere tool to become a central agent of what we can call “cognitive subsumption”, expanding the horizons of capitalist domination and exploitation. Thus, inspired by the Marxist analysis of “formal and real subsumption,” we problematize the notion of “ontological change” posed by AI and, at the same time, warn against the fetishization that conceals and naturalizes its political implications.

Keywords:

Artificial Intelligence, fetishization, technological capitalism, cognitive subsumption.

Introducción

Los mecanismos de control, opacidad y alienación que se consolidan mediante el uso de las tecnologías digitales de la información, principalmente a través de los que llamamos “cerebro social artificial” (inteligencia artificial), constituyen un proceso sociocultural de subsunción cognitiva a las lógicas del gran capital; por ello, en el presente trabajo, se plantea una crítica a las promesas tecnológicas y una reflexión sobre la urgente necesidad de imaginar, desde nuestras trincheras teóricas y prácticas, las alternativas emancipadoras en un presente cada vez más atravesado por algoritmos crípticos y plataformas digitales mercantilistas.

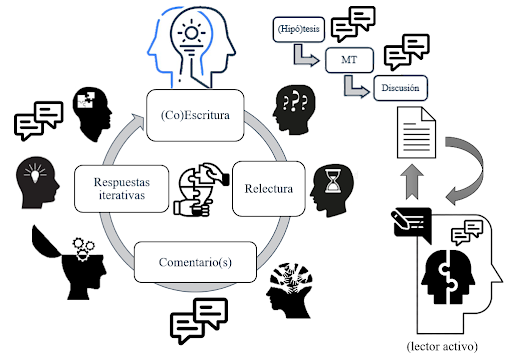

Metodológicamente, este texto se presenta como un ejercicio dialógico, articulado en forma de comentario crítico sobre una intervención académica discutida en el marco del Segundo Taller del Seminario “El Capital. Crítica a la economía política de Karl Marx”, celebrado los días 23 y 24 de enero del presente año en el Centro de Investigación y Docencia Económicas (CIDE). La “escritura dialógica” que queremos desarrollar aquí, inspirada en los enfoques “crítico-literario” y “antropológico-ético” de Mijaíl Bajtín (1982, 1977), enfatiza la interacción viva de múltiples voces en contextos y temporalidades situadas —en este caso, el espacio académico y el devenir de lecturas y comentarios mutuos—, que se articularon a modo de diálogo constructivo de la siguiente manera: escritura → lectura → comentario → respuesta(s) iterativa(s) → (co)escritura.

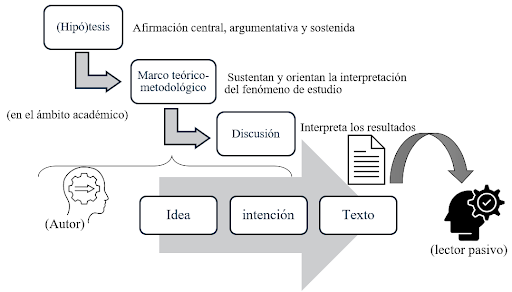

Para reflexionar acerca de la IA y su impacto en la generación del conocimiento, es importante realizar, en primera instancia, un breve contraste con la escritura tradicional (Cuadro 1), donde el autor es pieza clave y cuya voluntad interna dicta el sentido del texto, y con la (co)escritura (Cuadro 2), donde se disuelve toda autoridad unívoca en un flujo continuo de intervenciones. En el modelo tradicional, escribir es sellar un significado intencional que el lector debe descifrar y avanzar entre capas de implicaturas para reconstruir una intención perdida, sin alterar la estructura sacralizada del mensaje. Ahora bien, la (co)escritura no reconoce origen absoluto ni clausura del sentido: escribir, leer, comentar y responder, forman parte de un mismo acto de creación colectiva, donde el sentido se construye, se disputa, se transforma. La (co)escritura multiplica los núcleos posibles, explora los márgenes y desborda la voluntad inicial en una serie infinita de resonancias.

Cuadro 1. Esquema tradicional de escritura académica.

Cuadro 2. Ejercicio dialógico de coautoría.

De este modo, ningún nuevo texto es un producto cerrado, sino la reanudación constante de una cadena de intercambios en la que:

- La (co)escritura genera un enunciado “situado”.

- La lectura lo contextualiza y problematiza.

- El comentario aporta matices, críticas y sugerencias.

- La respuesta iterativa reelabora el enunciado original, incorporando lo leído y lo comentado.

- Se emprende de nuevo la escritura, iniciando otro ciclo dialógico.

Así, este círculo busca problematizar la idea de que el conocimiento no solo se expone, sino que se construye y define colectivamente, en un movimiento “vivo” de voces que se suscitan y responden mutuamente. Lo anterior permite analizar críticamente determinados contenidos, como reflexionar en conjunto sobre sus condiciones de posibilidad. A partir de Bajtín (1977), todo acto de lenguaje, incluida la escritura, involucra una responsabilidad-responsiva, tanto ética como política, pues al enunciar nos posicionamos frente al mundo y frente al otro (Mancuso, 2005; Libenson y Labandeira, 2016). Por nuestra cuenta, trataremos de recuperar la naturaleza situada y relacional del pensamiento humano, en tanto producto de encuentros, disensos y elaboraciones conjuntas.

En este sentido, se podrá reconocer en el formato dialógico un modo legítimo de generar conocimiento, que no solo es coherente con prácticas de investigación o acción, sino también con posiciones críticas del pensamiento occidental —a saber, “epistemologías del sur” y enfoques críticos contemporáneos, en consonancia con perspectivas que valoran el diálogo y la construcción colectiva del conocimiento en la investigación social (Freire, 1970; Fals, 1987)—. Cabe agregar que, tal como señalan Sánchez-Jiménez y Meza (2022), la escritura académica puede ser comprendida también como una práctica relacional que habilita procesos de subjetivación, aprendizaje mutuo y emergencia conceptual. Asimismo, Ghiso (2009) insiste en que el diálogo académico no es un mero intercambio de opiniones, sino una forma de resistencia frente al pensamiento único, capaz de abrir nuevas preguntas y horizontes de investigación.

Con todo, el presente artículo conjuga la especificidad de una intervención conceptual con el andamiaje crítico de la teoría marxista y la filosofía del lenguaje, estableciendo puentes entre la reflexión teórica, la práctica investigativa y el compromiso ético-político. De tal manera, será la voz del comentarista, Adrián Martínez Levy, la que dé inicio al desarrollo del texto desde la primera persona, abriendo un diálogo crítico con las aportaciones de la propuesta presentada por Alberto Tena, en una estructura que alterna análisis situado y reflexión teórica general.

El funcionamiento de la IA

Como parte del taller mencionado más arriba —en la mesa sobre “Ciencia y tecnología desde la Crítica a la economía política”—, el Dr. Alberto Tena Camporesi presentó avances de su investigación a través del texto inédito “Reconsiderando el desarrollo tecnológico: prospectivas sobre el ‘cerebro social artificial’”, donde se aprecia un aporte crítico para entender, desde distintas ópticas, el modo en que la Inteligencia Artificial (IA) reconfigura diversos aspectos de la alienación y la explotación capitalistas. Pero, para hablar de la IA desde un marco muy general, se entenderá esta como:

Un sistema […] basado en máquinas que, para un conjunto de objetivos explícitos o implícitos definidos por humanos, infiera, a partir de las entradas que recibe, cómo generar salidas —por ejemplo, predicciones, recomendaciones, decisiones o contenidos— que puedan influir en entornos físicos o virtuales. Estos sistemas varían en sus niveles de autonomía y capacidad de adaptación tras su despliegue, y se conciben como “agentes inteligentes” que perciben su entorno y actúan para maximizar sus posibilidades de cumplir sus objetivos. (Organisation for Economic Co-operation and Development [OECD], 2019)

Es necesario reconocer, en primer lugar, que el desarrollo de estas máquinas y agentes inteligentes se asienta sobre un complejo entramado de componentes técnicos que, lejos de ser neutros, están profundamente imbricados en las estructuras materiales y sociales del capitalismo contemporáneo. La IA se alimenta fundamentalmente de la expropiación masiva de datos humanos: cada interacción social, económica o afectiva en plataformas digitales genera “excedente conductual” (Zuboff, 2019), es decir, fragmentos de información que no eran producidos originalmente para ser comercializados, pero que son capturados, procesados y monetizados por empresas tecnológicas. Estos datos —obtenidos a través de redes sociales, búsquedas en Internet, compras en línea, dispositivos inteligentes y sensores urbanos— no son neutrales; contienen y reflejan los sesgos históricos de las sociedades capitalistas: racismo, sexismo, clasismo, colonialismo (Crawford, 2021).

En segundo lugar, los algoritmos de IA son mecanismos diseñados para capturar patrones en los datos históricos y optimizar resultados según intereses específicos como aumentar predicciones correctas, maximizar tiempos de permanencia, incentivar compras o manipular preferencias (Zuboff, 2019). Su lógica no privilegia criterios éticos o emancipatorios, sino métricas de eficiencia que refuerzan los objetivos corporativos de acumulación de capital. Además, los algoritmos reproducen y amplifican los sesgos existentes en los datos, mientras que los sistemas de puntuación crediticia, reconocimiento facial o recomendación de contenidos terminan fortaleciendo desigualdades estructurales (Crawford, 2021).

En ese sentido, los algoritmos que operan en los sistemas de IA están diseñados para maximizar métricas de eficiencia —precisión predictiva, optimización de recursos, velocidad de procesamiento—, subordinando otras consideraciones (éticas o sociales). Esta lógica responde a los intereses corporativos que dominan el ecosistema digital: expandir mercados, extraer datos personales y profundizar el control económico sobre la vida cotidiana (Zuboff, 2019). Así, la racionalidad algorítmica, lejos de ser un mecanismo objetivo, constituye una forma de racionalización económica que refuerza la acumulación de capital.

En suma, detrás de cada modelo de IA se esconde una compleja infraestructura material. Como analizan Crawford (2021) y Cancela (2023), el funcionamiento de la IA depende de centros de datos que consumen enormes cantidades de energía, así como de la extracción de minerales raros y estratégicos bajo condiciones de devastación ecológica y explotación laboral de quienes los extraen. Por si fuera poco, esto ocurre aunado al trabajo de miles de trabajadores precarizados —moderadores de contenido, etiquetadores de datos, entrenadores de algoritmos— que alimentan las bases de entrenamiento de las IA en condiciones invisibilizadas y desreguladas a escala global. En consecuencia, podemos considerar que la IA contemporánea resulta mucho más que un producto tecnológico; es un dispositivo técnico-político que prolonga y profundiza las dinámicas de la expropiación capitalista, transformando el conocimiento colectivo en mercancía y consolidando nuevas formas de alienación y dominación social.

Dicho lo anterior, es importante articular un diálogo entre las propuestas de Tena —arraigadas en el concepto marxiano de “cerebro social”— y algunas de las discusiones más recurrentes que tomaron lugar en el seminario: a saber, la fetichización, la alienación y la ontología social de Marx. Así, retomando los procesos de “subsunción formal” y “real” del trabajo en el capitalismo industrial del siglo XIX, se introduce aquí una discusión en torno a la categoría de “ontología” desde una doble acepción que responde a tradiciones filosóficas y políticas divergentes. Consideraremos, antes que nada, la clásica, o sea, la que se refiere a la disciplina que interroga las categorías fundamentales de la existencia como sigue: ¿qué consideramos real?, ¿cómo lo clasificamos?, ¿bajo qué condiciones lo aceptamos como existente?, ¿qué significados proyectamos sobre ello?

Esta vertiente no ofrece respuestas definitivas, pero cumple una función radical: nos obliga a cuestionar los presupuestos ontológicos naturalizados en nuestra comprensión del mundo. Por otro lado, permite distinguir la segunda acepción, más situada y procesual, que se aproxima a la idea heideggeriana de los “horizontes del ser” (Heidegger, 2003), entendidos como los marcos implícitos, pre-reflexivos y contextualizados, a través de los cuales un sujeto se comprende a sí mismo y su mundo. Con esto, dichos horizontes configuran una suerte de organicidad ontológica práctica, o de “gramática del ser” (Heidegger, 2003), que conforma la experiencia concreta.

Así pues, la lectura sobre la propuesta de Tena actualiza categorías clásicas del materialismo histórico, a la vez que plantea un desafío apremiante respecto al radical cambio paradigmático que se avecina en torno a la relación entre la “cooperación humana”, el “conocimiento colectivo” (o cerebro social) y la “acumulación capitalista” en un contexto donde la IA actúa como un operador o un cuasi-agente que, sin duda, está redefiniendo las fronteras de lo social. Para comprender mejor lo anterior, se presenta a continuación la discusión planteada por Tena:

Tal como analizó Marx en El Capital (Capítulo VI inédito; Capítulo XIII “Maquinaria y gran industria”) y en el “fragmento sobre las máquinas” de los Grundrisse, en los albores del capitalismo industrial (siglos XVIII-XIX), la “subsunción formal” operaba como un mecanismo de apropiación indirecta. El capitalista no intervenía en los métodos de producción tradicionales —como los talleres artesanales o la agricultura campesina—, pero se apropiaba del excedente mediante el control del mercado y la propiedad de los medios de producción. Por ejemplo, un tejedor manual podía seguir usando su telar, pero su producto final era comprado a bajo costo por un mercader para su venta en ciudades en expansión. Aquí, la plusvalía se extraía sin alterar la esencia del proceso laboral, manteniendo una autonomía relativa de las relaciones sociales preexistentes.

Con la Revolución Industrial, el capitalismo dio un salto cualitativo hacia la “subsunción real”. Las fábricas no solo concentraron trabajadores, sino que impusieron una reorganización técnica y social: líneas de ensamblaje, horarios estrictos y fragmentación de tareas. El conocimiento colectivo —el “cerebro social” construido con la cooperación entre obreros— fue capturado y materializado en máquinas (como el telar mecánico) que redujeron la habilidad humana a un complemento de la tecnología. Este proceso marcó un cambio ontológico manifiesto en el hecho de que “el trabajador ya no era un sujeto con control sobre su actividad, sino un engranaje en un sistema diseñado para maximizar la eficiencia y el control capitalista” (Marx, 2021, p. 451). En este contexto, el conocimiento colectivo —o “cerebro social”, según Marx— que alguna vez residió en la cooperación directa entre trabajadores, es apropiado por el capital y materializado en sistemas organizativos y maquinarias que refuerzan esta subordinación (Marx, 2009a, p. 405). Podemos actualizar esta noción señalando que, hoy en día, tecnologías como la IA refuerzan y extienden este proceso de expropiación a través de lo que denominaremos “cerebro social artificial”, en que las capacidades humanas (intelectuales) pasan a ser absorbidas y subsumidas en un entramado técnico de algoritmos y bases de datos cuya lógica responde a la acumulación de valor.

Ciertamente, todas estas transformaciones ligadas entre sí, como bien lo señala Tena, constituyen un terreno de debate muy fértil y esencialmente crítico en torno a la idea sugerida de “cambio ontológico”. De tal modo, es posible hablar de dos caminos distintos respecto de este cambio: 1) el que corresponde propiamente al materialismo histórico-dialéctico asociado a la tradición marxista y al concepto filosófico de “ontología” —que no solo describe “lo que hay”, sino que también reflexiona sobre los principios y condiciones necesarias y suficientes para que algo sea considerado “existente”—, y 2) el relativo al empleo de este mismo término, pero ahora desde una perspectiva más amplia, vinculada a la idea heideggeriana de los “horizontes del ser” en un contexto específico, es decir, a una cierta organicidad de preceptos y prenociones que permiten entenderse a uno mismo y operar dentro de un marco específico.

Ontología, cambio y cerebro social

En el enfoque materialista en Marx —sobre el cual se asienta todo su edificio teórico—, se despliega una perspectiva dialéctico-histórica que permite explicar los procesos de cambio social transhistóricos a partir de las relaciones materiales que han configurado la reproducción de la vida cotidiana, desde tiempos remotos hasta la actualidad. Así, se puede considerar que, conforme a la primera acepción definida, resulta complicado afirmar que el “cambio ontológico” señalado por Tena opere en la ontología del materialismo marxista; más bien, estos cambios referidos constituyen una especie de epifenómenos que responden a las estructuras fundamentales que operan dentro de la lógica misma del capitalismo. Se trata aquí de una ontología social, no de una ontología filosófica propiamente dicha.

En otras palabras, la ontología (filosófica) no cambia sustancialmente en el materialismo dialéctico, pues este sigue partiendo del fundamento de que “lo material” (id est, las relaciones materiales) condiciona la reproducción de la vida colectiva. Es en el seno de las relaciones materiales donde se determina un tipo particular de ser social que, a la par, delimita la conciencia individual: “no es la conciencia del hombre la que determina su ser, sino, por el contrario, el ser social es lo que determina su conciencia” (Marx, 2009b, p. 292). Este aspecto posicionó a Marx en el debate filosófico oponiéndose tanto a la tradición idealista alemana como a la materialista mecanicista, además de brindar una explicación inédita del cambio social.

Conforme a lo anterior, es posible afirmar que, en la actualidad, con el predominio casi absoluto del capitalismo, emergen fenómenos (como la subsunción del trabajo) que parecen expresar la reificación profunda de un modo de ser en el mundo y que, vistos desde la óptica de Marx, son producidos por la misma lógica capitalista. Estos epifenómenos del capitalismo dan la impresión de un cambio “ontológico” —como si estuvieran transformando la esencia de la “realidad”— cuando, en verdad, tan solo se inscriben en los mecanismos de reproducción material capitalistas que hoy no rigen, sin modificar la base ontológico-filosófica del materialismo, tal como la formuló el pensador alemán.

Así, Tena advierte sobre un “cambio ontológico” que, en realidad, puede entenderse como una reconfiguración o intensificación de aquellos procesos que ya estaban presentes: la subsunción formal y real del trabajo a la lógica del capital que ahora subsume el “cerebro social” a través de estas tecnologías, profundizando así las condiciones de dominación a partir de la creciente dependencia hacia estas. Este proceso es el que desemboca en lo que Tena describe como “cerebro social artificial”, un horizonte todavía incierto en el que la tecnología y los flujos de información juegan un papel determinante. La ilusión de un “cambio ontológico” en el capitalismo digital no es más que la forma actual que adopta el fetichismo de las fuerzas productivas: se atribuye la autonomía y el poder creador a tecnologías que, en realidad, son prolongaciones de las mismas relaciones sociales de producción, ahora mediadas por dispositivos algorítmicos y redes de extracción de datos.

Aquí es donde aparece la segunda acepción de la ontología (la social), entendida como el horizonte de realización del ser que hace viable la reproducción de la sociedad capitalista. Más que trastocar la ontología “materialista” de Marx —a nivel filosófico-abstracto—, estas transformaciones refuerzan los mecanismos que configuran el modo de ser propio del capitalismo, ofreciendo la apariencia de una mudanza esencial que, en el fondo, se sostiene sobre los fundamentos teóricos de la ontología del materialismo histórico-dialéctico. En ese entendido, es relevante considerar aquí una dialéctica que no trasciende al capitalismo, es decir, una que no nos mueve hacia otros modelos de reproducción material de la vida social y todo lo que ello conlleva. Esta es una “dialéctica interna”, profundamente resiliente, que ha permitido a este sistema reproducirse y readaptarse continuamente, al grado de presentarse (recurriendo al argot marxista) como un “mecanismo (onto)fetichizante” que reproduce la vida en su totalidad. Esta capacidad de autorreproducción parece reforzar su carácter ineludible, como lo sugiere la célebre frase atribuida a Fredric Jameson (2003, 2005), frecuentemente evocada por Slavoj Žižek y Mark Fisher: “es más fácil imaginar el fin del mundo que el fin del capitalismo”.

Es lícito afirmar que la propuesta de Tena acerca del cerebro social artificial se conecta directamente con el concepto de “alienación”, que ahora, bajo la subsunción de las capacidades cognitivas humanas, alcanza nuevas e insospechadas dimensiones. En particular, dicha alienación afecta a dos figuras fundamentales que operan en el mundo de las IA, y que deben ser claramente diferenciadas: por un lado, el “trabajador cognitivo” y, por otro, el “consumidor-usuario”.

En el primer caso, se trata de ingenieros, programadores, etiquetadores de datos y moderadores de contenido que, empleados en empresas y laboratorios dedicados al desarrollo de IA, ven su saber, creatividad y juicio subsumidos bajo procesos de automatización y racionalización capitalista. En el segundo caso, hablamos de aquellos que, en su interacción cotidiana con sistemas de IA —a través de búsquedas, consultas, producción de contenido o participación en plataformas— devienen en trabajadores inmateriales. La actividad no remunerada de estos —sus preguntas, clics, elecciones, imágenes, textos— alimenta y optimiza los modelos algorítmicos, convirtiendo su experiencia de vida en materia prima para la acumulación de capital. De esta forma, tanto el trabajador asalariado en las estructuras productivas de IA, como el consumidor atrapado en redes de captura de datos, experimentan nuevas formas de alienación: uno, bajo la explotación directa de su fuerza de trabajo intelectual; otro, bajo la explotación indirecta de su existencia cotidiana convertida así en dato y mercancía.

Esta doble explotación permite afirmar que ambas figuras, el trabajador cognitivo asalariado y el usuario no remunerado, participan activamente en el circuito de valorización del capital. La IA, en este contexto, no debe ser comprendida como un agente autónomo generador de valor, sino como una infraestructura tecnológica cuyo valor es actualizado, alimentado y sostenido por el trabajo humano. Así, la generación de plusvalor no es atribuible a la máquina en sí misma, sino al trabajo que la valoriza: el del ingeniero que entrena el modelo y el del usuario que, sin saberlo, lo nutre y perfecciona mediante su actividad cotidiana. De esta forma, la IA opera como “instrumento de subsunción real” del conocimiento social (la subsunción cognitiva), integrando el saber técnico y la experiencia vivida en un proceso de acumulación que disfraza la explotación de trabajo humano bajo formas algorítmicas, automáticas y supuestamente neutrales.

Capitalismo informacional

Aunque algunas posiciones críticas, como la de Jorge Veraza (2024), sostienen que no puede hablarse de plusvalor en el caso del usuario (por no existir una relación directa entre capital y trabajo formalizada), aquí se considera que esta lectura, si bien coherente con la teoría del valor en su formulación clásica, no alcanza a captar la especificidad estructural del “capitalismo informacional” y su modo expandido de extracción de valor (Fuchs, 2012). Cabe destacar que, en este nuevo régimen, la producción de valor no se limita a los confines de la fábrica o la oficina, ni a la compra explícita de fuerza de trabajo, sino que se extiende a través de procesos de captura, organización y monetización de externalidades cognitivas, afectivas y sociales que emergen en la vida cotidiana (Fuchs, 2012).

Desde esta perspectiva, el trabajador que desarrolla los sistemas de inteligencia artificial y el usuario que los alimenta de manera no remunerada con sus elecciones, interacciones y expresiones, participan de un mismo proceso de valorización del capital digital, aunque desde posiciones distintas en la cadena de explotación. Y es que dicha explotación ya no se basa únicamente en el tiempo de trabajo productivo visible, sino que se infiltra en el lenguaje, el deseo, la atención y la imaginación, transformando incluso las actividades no laborales en insumos valorizables. El capital ya no necesita comprar directamente la fuerza de trabajo para extraer valor de ella: le basta con interceptarla, modularla y canalizarla algorítmicamente. Esta forma intensificada de explotación opera bajo el signo del fetichismo tecnológico, que oculta el trabajo vivo implicado en la generación de datos y la reproducción algorítmica del mundo.

Ahora, el capital no solo expropia la fuerza de trabajo física y la vida en sociedad, como advirtió Marx; se inmiscuye en aquello que constituye uno de los rasgos más esenciales de la especie humana: la capacidad de síntesis creativa. El saber colectivo, históricamente construido y transmitido, es capturado y reorganizado en infraestructuras algorítmicas opacas, anidado en tecnologías crípticas cuyo control y beneficio quedan concentrados en manos de unos pocos. Pero ¿quiénes son esos pocos? Fundamentalmente, los grandes conglomerados tecnológicos —empresas como Meta, Alphabet (Google), Microsoft, Amazon y OpenAI—, que monopolizan las infraestructuras de datos, los sistemas de procesamiento cognitivo automatizado y los flujos de conocimiento digitalizado.

Podemos considerar que estas corporaciones, bajo la apariencia de innovar y democratizar el acceso a la Inteligencia Artificial, en realidad ejercen un nuevo régimen de propiedad privada sobre el saber social, estableciendo una aristocracia algorítmica que controla las condiciones de producción simbólica y cognitiva a escala global. La inteligencia artificial, así entendida, no constituye una liberación de las capacidades humanas, sino la nueva forma de subsunción material, organizada a través de redes de extracción de datos, plataformas de interacción social y procesos de modelado predictivo que convierten la experiencia vivida en un insumo más de la reproducción ampliada del capital.

Resulta muy difícil reflexionar sobre la lógica de la Inteligencia Artificial sin reconocer los mecanismos de ocultamiento y fetichización propios del capitalismo contemporáneo, que alcanzan dimensiones alarmantes en múltiples esferas. Por citar algunos casos, la coexistencia de fenómenos como los desplazamientos forzados de poblaciones, la concentración extrema de riqueza en manos de una élite “tecnofeudal” (Varoufakis, 2023) y la normalización de la violencia bajo narrativas de seguridad y progreso, ofrecen el telón de fondo en que debe situarse el análisis del “cerebro social artificial”. La IA no es una innovación neutra (políticamente hablando); reiteramos que es un dispositivo de subsunción del trabajo cognitivo humano, tanto el de los trabajadores asalariados en las industrias tecnológicas como el de los usuarios cuya actividad cotidiana —comentarios, interacciones, elecciones— es capturada, procesada y convertida en insumo para la reproducción ampliada del capital.

No estamos ante una emancipación de las capacidades humanas, sino ante la reorganización e instrumentalización de estas dentro de un régimen de explotación cognitiva que disimula sus fundamentos materiales bajo la apariencia de innovación tecnológica. En este contexto, es posible hablar de un auténtico “fetichismo tecnológico”, el cual presenta a las Inteligencias Artificiales como fuerzas no solamente “autónomas”, “naturales” e “inevitables”, sino capaces (“por sí mismas”) de transformar la sociedad; de guiarnos hacia lo que se ha dado en llamar “singularidad tecnológica” y “transhumanismo”. Por todo ello, resulta preciso des-fetichizar estas promesas y futuros “inevitables”, pues detrás de ellas se encubre el hecho de que estas herramientas son productos de relaciones sociales de explotación, moldeadas y controladas por el gran capital.

La Inteligencia Artificial es un mecanismo “ultrasofisticado” que aprisiona el conocimiento en algoritmos de aprendizaje, escritos por determinado tipo de persona, que se alimenta de un particular tipo de dieta informática (principalmente patriarcal, blanca, supremacista, meritocrática, opresora, etc.). Al controlar el progreso tecnológico y ocultar las relaciones de explotación que lo sostienen, este fetichismo tecnológico no hace más que invisibilizar mejor la perpetuación de aquella (segunda) acepción socio-ontologizante del capitalismo y, peor aún, dificultar más la posibilidad de imaginar alternativas de emancipación viables.

Al actualizar la noción de “cerebro social” en el contexto contemporáneo, la contribución de Tena nos invita a reflexionar sobre la capacidad del capitalismo para metabolizar sus contradicciones internas y convertirlas en fuentes de expansión o, en este caso, en un complejísimo y encriptado “diseño socio-ontologizante” de su realidad. La Inteligencia Artificial, como expresión de una subsunción cognitiva, no solo redefine las relaciones entre trabajo, capital y entorno social, sino que plantea escenarios profundamente inquietantes para el futuro del desarrollo humano. Y entre los desafíos más apremiantes se encuentra la influencia que estas tecnologías ejercen, desde edades cada vez más tempranas, sobre las nuevas generaciones.

La disponibilidad ubicua de dispositivos inteligentes —que, como se ha anunciado, serán integrados de manera aún más directa en los cuerpos mediante tecnologías portables o implantables— plantea una cuestión crucial para quienes se desempeñan en el ámbito educativo: ¿serán los jóvenes capaces de conservar las habilidades básicas del intelecto, como el análisis, la síntesis o la reflexión crítica? Más aún: ¿podrán preservar una sensibilidad creativa auténticamente propia, capaz de imaginar alternativas posibles frente al orden vigente? La preocupación aquí no se limita a la pérdida de destrezas cognitivas aisladas, sino a la posible erosión de la capacidad de agencia simbólica, de imaginación utópica y de construcción autónoma de sentido, pilares fundamentales para cualquier proyecto liberador.

Resulta fundamental profundizar en este análisis para comprender de manera crítica cómo las nuevas tecnologías moldean, reproducen y expanden las relaciones de poder existentes; pero, sobre todo, para imaginar —fuera de esa caja negra— nuevas posibilidades de emancipación en un contexto cada vez más atroz y desesperanzador. La crítica al desarrollo tecnológico no puede escindirse de otra, hecha a las relaciones sociales que lo posibilitan, como propone Tena. Cualquier intento de transformación exige confrontar, al mismo tiempo, los dispositivos técnicos y los modos de vida y producción que los configuran (hallazgo mutuo). A partir de esto, se vuelve imprescindible complementar la crítica marxista (en Tena) con una reformulación del trabajo desde la perspectiva de la ética bajtiniana: no basta con diagnosticar las estructuras de subsunción del trabajo (real, formal y cognitiva); es oportuno recuperar la noción dialógica de “acto ético” (del ruso postupok) —como respuesta singular, responsable y situada frente al otro y frente al mundo (Bajtín, 1977, p. 9).

Imaginar horizontes alternativos no solo implica proyectar nuevas formas de organización económica, sino también reinstituir las condiciones de posibilidad de una creatividad encarnada, dialógica y abierta, capaz de resistir la automatización del sentido y la captura de la subjetividad. La tarea crítica, entonces, no reside únicamente en denunciar las formas actuales de explotación cognitiva, sino en reactivar —desde cada acto— la potencia ética y simbólica del trabajo humano como gesto de construcción de otros mundos posibles.

Hacia una ética del acto en la era del “cerebro social artificial”

Con todo lo expuesto hasta aquí, es posible afirmar que el desarrollo de la IA, y su creciente rol en la configuración de lo social, plantea múltiples desafíos a la crítica marxista y a otras corrientes filosóficas que estudian los fundamentos deónticos de la existencia. Además, gracias a las reflexiones a las que nos invita Alberto Tena, el concepto “cerebro social artificial” permite profundizar en la forma en que el capitalismo tecnológico subsume el trabajo físico y la cooperación social alrededor de este, como las capacidades cognitivas y simbólicas, extendiendo así las dinámicas de explotación y fetichización que caracterizan al modo de producción contemporáneo y a la vida social en el mundo capitalista.

Podemos sumar aquí el viraje en la tradición marxista inspirado en la filosofía del “acto ético” de Mijaíl Bajtín (1977) y en las reflexiones sobre la politicidad de la toma de palabra (Mancuso, 2005; Libenson y Labandeira, 2015), a fin de proponer una relectura crítica de la IA como dispositivo de construcción óntico-encriptada de la realidad social. En la filosofía antropológica de Bajtín (1977), todo acto —y muy especialmente aquel relacionado con la palabra— involucra una responsabilidad y una responsividad tanto éticas como políticas, pues cada vez que hablamos o escribimos asumimos una posición frente al mundo y frente a los otros:

Cualquier pensamiento mío, con su contenido, es mi acto ético [postupok] individual y responsable; es uno de los actos éticos de los cuales se compone mi vida única, concebida como un actuar ético permanente, porque la vida en su totalidad puede ser examinada como una especie de acto ético complejo: yo actúo mediante toda mi vida, y cada acto y cada vivencia aislada es un momento de mi vida en cuanto actuar ético. Este pensamiento en cuanto acto ético es integral: tanto su contenido semántico, como el hecho de su presencia en mi conciencia real de hombre [persona] singular, de hombre totalmente determinado, que actúa en un tiempo determinado y en determinadas condiciones (es decir, toda la historicidad completa de mi pensamiento): ambos momentos, pues, tanto el semántico como el histórico individual (fáctico) están unidos indivisiblemente en la valoración de mi pensamiento concebido como acto responsable. (Bajtín, 1977, p. 9)

Este postulado rebasa la mera enunciación lingüística para situarse en cualquier forma de producción histórica de sentido, incluida la mediación tecnológica contemporánea. Si se traslada esta idea al uso de la IA, se puede constatar que cada interacción con sistemas automatizados constituye un “acto” que influye en el tejido social y en la forma en que se organizan las relaciones de poder. Como bien lo sintetizan Libenson y Labandeira (2015, pp. 6-7):

Tanto lo político como lo ético no son concebidos aquí como dominios prediscursivos de lo social. Por el contrario, son entendidos como dimensiones constitutivas de todo enunciado dado que se fundan en el espacio habilitado por el acontecimiento discursivo en el que la respuesta al enunciado es, a la vez, el lugar en el que se configuran diferentes grados de responsividad del sujeto frente al otro (Libenson y Labandeira, 2016, pp. 6-7, las cursivas son nuestras).

Así pues, es preciso entender el carácter “ético generativo-constructivista”, por llamarlo de algún modo, que se refiere a la construcción social e histórica (materialista y dialéctica) de la intersubjetividad política.

Si todo enunciado se define por su carácter responsivo/responsable, es posible pensar la emergencia de la dimensión política del sujeto a partir de esta instancia de interpelación discursiva. Y es precisamente en las cadenas dialógicas de repeticiones y diferencias entre enunciados donde se componen nuevos sentidos que, por su naturaleza responsiva/responsable, interpelan al sujeto y fundan, así, la posibilidad de constitución discursiva de su politicidad. La respuesta-responsable del sujeto, entonces, al inaugurar la dimensión ética de su decir (Bajtín, 1997), funda así la dimensión política de su subjetividad (Libenson y Labandeira, 2016, p. 19; las cursivas son nuestras).

El compromiso con la responsabilidad no se reduce a atender listas de control o protocolos de ética en el desarrollo de algoritmos. Antes bien, se trata de asumir que la mediación tecnológica es, en sí, un espacio de subjetivación que habilita las condiciones de posibilidad psíquico-materiales de reproducción ideológica, en donde se ejercen valores, ideologías y jerarquías. Al procesar los datos sesgados de millones de usuarios y convertirlos en patrones “objetivos”, la IA participa de la creación de narrativas globales que pueden coadyuvar a perpetuar las desigualdades existentes.

Un ejemplo ilustrativo de esa perpetuación puede observarse en los sistemas de reconocimiento facial implementados por empresas como Amazon (a través de su programa Rekognition), sobre la que estudios independientes han demostrado tasas de error significativamente más altas en el reconocimiento de rostros de personas negras y latinas en comparación con rostros blancos, reforzando así patrones históricos de discriminación (Buolamwini y Gebru, 2018). De manera similar, los algoritmos de recomendación en sitios como YouTube han sido ampliamente criticados por amplificar discursos extremistas y desinformación, al priorizar contenido altamente polarizante que goza de mayor tiempo de permanencia en la plataforma, reproduciendo jerarquías de poder discursivo y segmentaciones ideológicas (Tufekci, 2018).

Como es posible apreciar, la mediatización en el caso de la IA no se desarrolla de forma neutral ni espontánea, sino que responde a un proceso material e histórico profundamente anclado en las relaciones sociales de producción y poder. Los sistemas de IA funcionan mediante el entrenamiento de algoritmos sobre grandes volúmenes de datos generados por la actividad humana en el espacio virtual: interacciones sociales, transacciones económicas y expresiones culturales. Dichos datos, extraídos, sistematizados y procesados algorítmicamente, ayudan a identificar patrones de comportamiento que luego son utilizados para generar respuestas automatizadas, segmentar mercados, predecir decisiones o modelar flujos de información. Así, la IA no produce conocimiento autónomo, sino que reconfigura fragmentos de la vida social preexistente bajo criterios de eficiencia, rentabilidad y control (Crawford, 2021).

Como se abordó más arriba, en este circuito de mediatización, el trabajo no desaparece; más bien, se reconfigura en una doble forma complementaria que sostiene la valorización del capital algorítmico. De tal modo, en el proceso de extracción, el trabajo vivo asalariado activa la máquina y la actividad social vivida la mantiene funcional y rentable. La IA no genera valor por sí sola: es el trabajo humano, en sus múltiples formas, el que valoriza a la IA en tanto capital, integrándola en circuitos de acumulación que ocultan su carácter explotador bajo la apariencia de eficiencia técnica o progreso inevitable. Esta doble forma de captura permite al capital apropiarse del conocimiento, la atención y la experiencia subjetiva como fuentes de plusvalor, reafirmando que, incluso en el capitalismo digital, no hay automatismo sin trabajo humano previo, ni inteligencia artificial sin vida social explotada.

Los recursos que sustentan este proceso son múltiples: por supuesto, la fuerza de trabajo humana especializada y el conocimiento colectivo son subsumidos, pero también los recursos naturales —como los minerales estratégicos necesarios para la construcción de hardware y la energía masiva requerida por los centros de datos— y recursos simbólicos, dado que los lenguajes, las culturas y las prácticas sociales mismas se convierten en información de entrenamiento capitalizable (Cancela, 2023). El valor no surge de la creación de algo radicalmente nuevo, sino de la captura y reorganización del excedente cognitivo de las sociedades humanas. La IA se ha convertido en un dispositivo de subsunción del conocimiento social apropiando la actividad vital de los individuos, estructurándola algorítmicamente y transformándola en plusvalor mediante mecanismos de publicidad dirigida, segmentación social o servicios predictivos (Zuboff, 2019). De esta forma, la IA actúa como un nuevo operador en la reproducción ampliada del capital, desplazando la agencia humana y reforzando la estructura de dominación material bajo la apariencia de innovación tecnológica.

También cabe subrayar que este proceso no se desarrolla en un vacío social ni bajo una lógica técnica autónoma. Insistimos una vez más: detrás de la IA operan conglomerados corporativos —como Alphabet (Google), Meta (Facebook), Microsoft, Amazon y OpenAI— que controlan las principales infraestructuras de datos, el diseño de los sistemas de procesamiento algorítmico y las plataformas de interacción masiva. Lo alarmante es que estos actores, en definitiva, no persiguen el progreso del conocimiento humano como fin en sí mismo, sino la expansión de sus posiciones de poder económico, político y simbólico. Los intereses que animan el despliegue de la IA se orientan a maximizar la acumulación de capital mediante la captura de la atención, la producción de dependencia tecnológica y la generación de mercados predictivos cada vez más eficientes.

Las estrategias empleadas para alcanzar estos fines combinan diversas tácticas de mediación y naturalización: la opacidad de los algoritmos, que dificulta la comprensión pública de sus lógicas de funcionamiento; la promoción de narrativas de inevitabilidad tecnológica, que presentan la automatización como un proceso ineluctable, y la fetichización de la innovación, que disfraza procesos de expropiación de conocimiento y trabajo bajo la apariencia de “progreso emancipador”. Al mismo tiempo, se refuerzan mecanismos de segmentación social, personalización de contenidos y manipulación afectiva, diseñados para intensificar la explotación del excedente cognitivo de los usuarios y profundizar su integración subordinada en el circuito del capital digital. Así, la inteligencia artificial actúa como operador técnico y también como dispositivo político-económico de reproducción de las jerarquías globales de poder, enmascarado bajo la estética de la innovación y el discurso de la neutralidad.

De manera más preocupante aún, se puede considerar que la mediatización mutila en las nuevas generaciones capacidades que trascienden la mera síntesis o el pensamiento crítico, incidiendo incluso en su propia creatividad y en esa poiesis de la que habló Aristóteles, al negarles la posibilidad de gestar producciones auténticamente humanas. En la era del “cerebro social artificial”, la delegación de la creatividad a sistemas algorítmicos amenaza con erosionar esta capacidad humana fundamental, reduciendo la producción simbólica a mera recombinación de lo existente. Y la crisis no es solo epistemológica o técnica, sino ontológica: si la IA impone estructuras de pensamiento preconfiguradas, ¿cómo garantizar que la humanidad conserve su potencia creadora y la capacidad de imaginar otros mundos posibles?

La IA y el poder: entre el fetichismo tecnológico y la lógica del capital

Tal como ocurrió con los grandes conglomerados mediáticos desde el primer cuarto del siglo pasado, el “cerebro social artificial” puede cristalizar ahora relatos dominantes y naturalizar la supremacía de ciertas narrativas, al mismo tiempo que invisibiliza otras. En este panorama, la IA se presenta a menudo con una máscara de imparcialidad. Sin embargo, los algoritmos subyacen a relaciones de poder específicas; se diseñan y entrenan en contextos corporativos, bajo modelos de negocio que priorizan la rentabilidad y el control. El resultado es una confluencia entre el fetichismo tecnológico y la lógica del capital donde el producto algorítmico es exhibido como un avance incuestionable o un simple progreso técnico sin tensiones sociopolíticas. Lejos de ello, las decisiones sobre qué datos recolectar, cómo procesarlos y qué usos darles, representan actos éticos de amplia repercusión política.

A partir de lo anterior, se puede considerar que el rasgo ontológicamente disruptivo de esta nueva forma de subsunción radica en que penetra la esfera que define nuestra condición de especie: la producción de sentido, el lenguaje y la cooperación simbólica. La IA encarna esta apropiación, presentándose como “otro agente” que, en teoría, puede simular procesos creativos, emocionales e incluso decisionales. Si bien la tecnología no es independiente —está condicionada a la extracción de datos y a la configuración de sus diseñadores—, la ilusión de su autonomía, al parecer, contribuye a consolidar la alienación cognitiva.

Para la crítica marxista, este fenómeno plantea sin duda una “intensificación de la fetichización”. El cerebro social artificial se percibe como una entidad autosuficiente, por encima de las relaciones sociales y materiales que lo hacen posible. Esto dificulta imaginar un horizonte más allá del capitalismo tecnológico, pues la IA es presentada como una evolución histórica lógica, omitiendo las contradicciones y los conflictos que la acompañan. En este sentido, la reificación del cerebro social artificial se proyecta ahora en una dimensión virtual, pero no por ello menos real en sus efectos ideológicos.

En cada acto comunicativo con la IA, el mundo se “refracta”, prefigurado por sus arquitectos en el tejido dialógico de los sujetos reales. Es imperativo subrayar la necesidad de una responsabilidad activa y una responsividad plenamente consciente (ambas éticamente encausadas), que orienten los desarrollos y aplicaciones tecnológicas hacia horizontes más justos y equitativos, dado que la IA refleja y reproduce una visión del mundo moldeada por quienes diseñan estas tecnologías. Y como estas estructuras algorítmicas influyen en el diálogo social y en la construcción de significados, resulta fundamental asumir una consciencia crítica en su uso, de modo que su desarrollo y aplicación no contribuyan a perpetuar las inequidades sociales.

Se trata de rechazar el determinismo tecnológico y reconocer que los seres humanos siguen interviniendo en todos los procesos que configuran estos algoritmos. Por otra parte, el proceso educativo vinculado a la IA no puede concebirse simplemente como transmisión instrumental de técnicas y diseño de prompts, sino como un acto ético (postupok) en el sentido bajtiniano, pues toda interacción constituye una respuesta singular, responsable y situada frente a un mundo saturado de mediaciones técnicas. Enseñarnos a interrogar a la Inteligencia Artificial es, por tanto, enseñarnos a “responder”, tanto técnica como éticamente frente a la palabra automatizada, es decir, frente a los sentidos ya preprogramados.

Cada gesto de deconstrucción crítica respecto a un sesgo algorítmico, cada cuestionamiento del fetichismo tecnológico, constituye un acto en donde el estudiante asume la responsabilidad ante su propio saber, ante los otros y ante el futuro común. La toma de conciencia de que a la IA subyacen este tipo de procesos e intereses que se han tratado aquí es, en sí misma, un acto ético que resiste la subsunción automática de la subjetividad. No olvidamos, sin embargo, que también existe una responsabilidad ética que compete a quienes legislan y regulan estos ámbitos, y de la misma forma que la industria química o el sector energético requieren normativas específicas para prevenir daños medioambientales y sociales, la IA demanda criterios de transparencia, responsabilidad y participación ciudadana.

Es posible ver con claridad ahora, apoyados en la filosofía bajtiniana, que ningún enunciado —y por ende, ningún uso de la IA— es un mero intercambio de información, sino un tipo de relación con un proyecto de mundo. Por ello, la responsabilidad radica, por un lado, en la elección de las herramientas, en la forma de documentar su empleo y, por otro lado, la responsividad repercute en las rutas de acción que emprendemos en torno a estos instrumentos digitales. Adoptar una perspectiva ético-crítica frente a la IA implica, por ejemplo, exigir sistemas abiertos y auditables, subrayar la importancia de la soberanía de datos y fomentar la diversificación de voces en los procesos de diseño algorítmico.

Al hacerlo, nos alejamos de la visión tecnocrática según la cual la IA es un fin en sí mismo o, en el mejor de los casos, un mero “facilitador” de la modernización. Por el contrario, se reivindica el carácter crítico-dialógico y situacional de la tecnología, resaltando la politicidad inmanente a toda práctica digital. En paralelo, es importante reconocer la dimensión histórica de estos procesos: la IA no emerge de un vacío, sino en un contexto signado por la hegemonía del capital, la precarización laboral, el racismo estructural, la crisis climática y el neocolonialismo genocida. Comprender esta coyuntura es importante para discernir las inercias y los intereses que guían el desarrollo tecnológico.

Epílogo: La dialéctica interna del capitalismo tecnológico y la imaginación de otros horizontes

Según lo esbozado al inicio de este trabajo, el cerebro social artificial se inserta en la llamada dialéctica “interna” del capitalismo, caracterizada por una enorme capacidad de adaptación y expansión que a muchos ha llevado a aseverar la imposibilidad de un cambio sistémico. Sin embargo, la visión marxista ha mostrado que las contradicciones internas de este modo de producción abren fisuras y posibilitan la emergencia de formas de lucha y resistencia. En el plano cognitivo, dichas fisuras pueden aparecer cuando se evidencia la dependencia de la IA respecto a infraestructuras materiales y trabajos invisibilizados, como la minería de datos o la moderación de contenidos.

Visibilizar estas condiciones puede coadyuvar a sentar las bases para una respuesta colectiva hacia los impactos negativos de estas tecnologías que trascienda la resignación. Para ello, se requiere una praxis dialógica arraigada en la conciencia de que la tecnología no es solo un “producto”, sino un proceso en el que participan múltiples actores y donde las decisiones nunca son neutrales. Siguiendo la óptica bajtiniana, esta praxis se nutre de la responsividad y la responsabilidad ante el otro, reconociendo que cada decisión tecnológica configura un diálogo con las generaciones presentes y futuras.

El hecho de que la IA incida en la creación de narrativas, en la selección de noticias, en diversos niveles y actividades de la vida cotidiana, incluyendo los de la administración pública, e incluso en los procesos artísticos, indica su potencial de penetración en la cultura y en las subjetividades contemporáneas. Esto no debería llevar a la parálisis, sino a la convicción de que todavía existe margen de maniobra para regular y reorientar el uso de estas herramientas. Al igual que en otros momentos históricos, la resistencia puede articularse en torno a la apertura de datos, el desarrollo de software libre y la formación de colectivos que diseñen aplicaciones con criterios de justicia social.

De este modo, podemos considerar que el debate planteado en torno a la propuesta de categoría “cerebro social artificial” abre un capítulo trascendental en la crítica marxista del capitalismo, al proyectar la alienación y el fetichismo como categorías observables (más allá del ámbito meramente productivo) y al adentrarse en la dimensión cognitiva, identificando sus impactos y afectaciones. Desde una lectura bajtiniana, cada intercambio con la IA se erige en un acto ético que exige responsabilidad política y anticipación. Esto supone forjar una conciencia crítica ante los sesgos, la opacidad y la hiperconcentración de poder que caracterizan a las infraestructuras tecnológicas actuales.

La tarea no es sencilla, pues el fetichismo tecnológico se sustenta en la promesa de eficiencia, innovación y progreso incesante, reforzada por las corporaciones y las narrativas mediáticas. Con todo, la propia historia del capitalismo demuestra que los proyectos de transformación brotan de las grietas e inestabilidades generadas por la explotación y la desigualdad. Si la IA supone una herramienta sin precedentes, ¿también podría servir de catalizadora para una rearticulación de luchas y reflexiones encaminadas a imaginar otros mundos posibles? Quizá en estos mundos la cooperación humana no sería regulada por la rentabilidad y la lógica del valor, sino por los principios de la solidaridad, la democracia y la justicia.

Las ideas que aquí se han expuesto —desde el análisis de la subsunción hecho por Marx hasta la filosofía bajtiniana del acto ético— recuerdan que la tecnología no es un fin último, sino parte de un proceso social e histórico mucho más amplio. Por ello, superar la (onto)fetichización de la IA y concebirla como un escenario dialógico donde se negocian significados y proyectos de vida es, quizá, el primer paso para construir una alternativa que rescate la potencia creadora de la humanidad en lugar de subordinarla a la acumulación capitalista. Así, el epílogo de esta era tecnológica sigue escribiéndose a diario, en cada interacción y acto comunicativo que asumimos con responsabilidad y compromiso político.

Bibliografía y fuentes consultadas

Bajtín, M. (1985). Estética de la creación verbal. Siglo XXI.

Bostrom, N. (2005). In Defense of Posthuman Dignity. Bioethics, 19(3), 202–214. https://doi.org/10.1111/j.1467-8519.2005.00437.x

Buolamwini, J. y Gebru, T. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. Proceedings of Machine Learning Research, 81, 1–15.

Cancela, E. (2023). Utopías digitales: Imaginar el Fin del capitalismo. Verso.

Crawford, K. (2021). Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence. Yale University Press.

Fuchs, C. (2012). Una contribución a la crítica de la economía política del capitalismo informacional transnacional. Nómadas, 36, 26-41.

Ghiso, A. (2009). Investigación dialógica, resistencia al pensamiento único. Maestros y maestras gestores de nuevos caminos. Educación, conocimiento y poder, 50(1), 12-27.

Heidegger, M. (2003). Ser y tiempo. Ediciones Universitarias de Valparaíso.

Jameson, F. (2003). Future City. New Left Review (21), 65–79.

Jameson, F. (2005). Archaeologies of the Future: The Desire Called Utopia and Other Science Fictions. Verso Books.

Kurzweil, R. (2005). The Singularity Is Near: When Humans Transcend Biology. Viking.

Libenson, M. y Labandeira, L. (2016). La dimensión ética de la palabra: responsabilidad y politicidad en perspectiva bajtiniana. Kalagatos, 3(2), 5-23.

Mancuso, H. (2005). La palabra viva. Teoría verbal y discursiva de Michail M. Bachtin. Paidós.

Marx, K. (2009a). Elementos fundamentales para la crítica de la economía política (Grundrisse) 1857-1858 (Vol. II). Siglo XXI.

Marx, K. (2009b). Prólogo a la Contribución a la crítica de la economía política. En K. Marx y F. Engels, Textos 1: Filosofía. Siglo XXI.

Marx, K. (2021). El Capital. Crítica de la economía política. Libro I. El proceso de producción del capital. Siglo XXI.

Meta (2021). Introducing Meta: A Social Technology Company. Meta Newsroom. https://about.fb.com/news/2021/10/facebook-company-is-now-meta/

More, M. (1990). Transhumanism: Toward a Futurist Philosophy. Extropy Institute.

OpenAI. (2018). An Open Letter: Our Charter. https://openai.com/charter

Organisation for Economic Co-operation and Development. (2019). Recommendation of the Council on Artificial Intelligence (OECD/LEGAL/0449). OECD Publishing. https://legalinstruments.oecd.org/en/instruments/OECD-LEGAL-0449

Russell, S. y Norvig, P. (Coords.). (2010). Artificial intelligence: A modern approach. Pearson.

Sánchez-Jiménez, D. y Meza, P. (2022). Posicionamiento y dialogicidad en la escritura académica y profesional. New York City College of Technology, CUNY.

Tufekci, Z. (10 de marzo de 2018). YouTube, the Great Radicalizer. The New York Times. https://www.nytimes.com/2018/03/10/opinion/sunday/youtube-politics-radical.html

Varoufakis, Y. (2023). Technofeudalism: What Killed Capitalism. The Bodley Head.

Veraza, J. (2023). Karl Marx, la inteligencia artificial y el gobierno despótico de la producción. Ítaca.

Vinge, V. (1993). The Coming Technological Singularity: How to Survive in the Post-Human Era. [Documento de trabajo] NASA. https://ntrs.nasa.gov/api/citations/19940022856/downloads/19940022856.pdf

Volóshinov, V. (2009). El marxismo y la filosofía del lenguaje. Ediciones Godot.

Zuboff, S. (2019). The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power. PublicAffairs.